WordPress建站流程(五)SEO优化

通过前面的四篇教程,Wordpress已经可以很出色的运行了,建设网站肯定需要流量,而自然搜索流量是非常重要的…

通过前面的四篇教程,Wordpress已经可以很出色的运行了,建设网站肯定需要流量,而自然搜索流量是非常重要的流量来源,所以SEO (Search Engine Optimization) 优化是必须的步骤。

SEO其实就是搜索引擎优化的意思,现在国内主流的搜索引擎是百度、必应、搜狗、360搜索、神马搜索,而谷歌搜索因为已退出了中国大陆且目前国内无法访问,如果不是做外贸的网站可以忽略。

WordPress SEO优化步骤:

各主流搜索引擎的站长平台

建议注册各搜索引擎的站长平台并添加自己的网站。

安装Yoast SEO插件

Yoast SEO插件是Wordpress用户最受欢迎的SEO插件。

Sitemap.xml 站点地图

可方便通知搜索引擎有哪些可供抓取的网页。

robots.txt 详解

告诉网络搜索引擎的蜘蛛,此网站中的哪些内容是不希望被抓取的。

有关SEO的一些总结

各主流搜索引擎的站长平台

各主流搜索引擎的站长平台注册/登录地址:

- 百度搜索资源平台: https://ziyuan.baidu.com/

- 必应Bing 网站管理员工具: https://www.bing.com/toolbox/webmaster/

- 搜狗站长平台: http://zhanzhang.sogou.com/

- 360站长平台: http://zhanzhang.so.com/

- 神马站长平台: https://zhanzhang.sm.cn/

- 谷歌 Google Search Console: https://www.google.com/webmasters/tools/home

建议:以上都注册并添加自己的网站。

安装Yoast SEO插件【推荐】

免费的Yoast SEO插件是Wordpress用户最受欢迎的SEO插件,简单易用,且功能强大,虽然有Yoast SEO Premium收费版,但使用免费版的功能也基本满足常日常SEO需求了。

安装完毕后,Yoast SEO会自带中文语言包,所以根据配置向导设置应该没什么难度。

配置向导结束后,在Wordpress后台中,打开:SEO – 搜索外观 将首页的相关信息补齐,例如: SEO title 与 Meta description 等信息。然后依次配置内容、分类等页面的SEO信息。

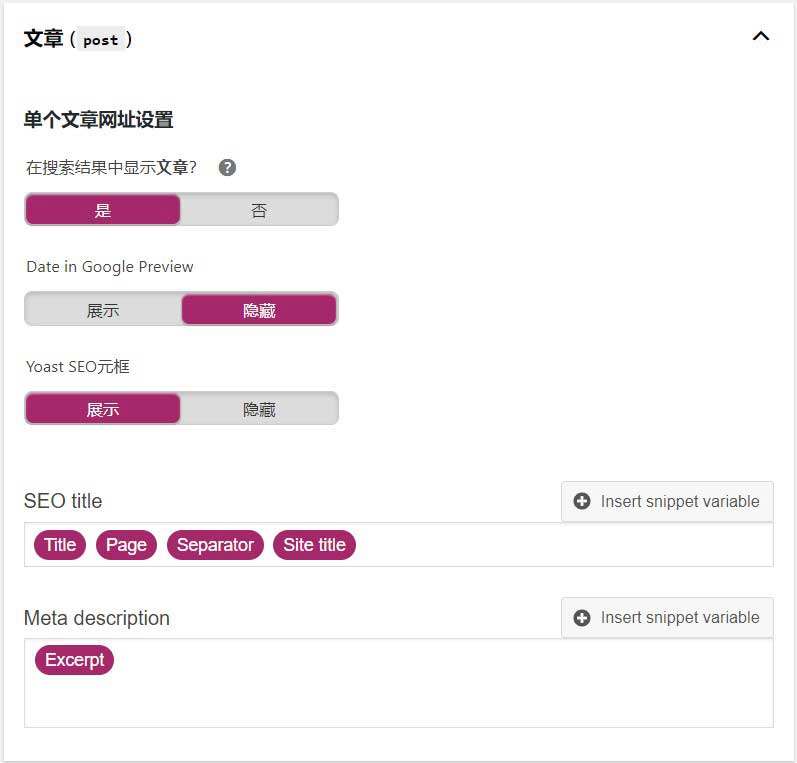

除首页外,例如文章、分类等页面的 Meta description 信息可以填入:%%excerpt%% 将自动获取摘要。如下图:

以上设置的信息,也可以在发表文章的时候手动修改。

Sitemap.xml 站点地图

最简单的 Sitemap 形式,就是XML 文件,Wordpress默认是没有提供 Sitemap 的,所以需要自己添加。Yoast SEO 这么牛的SEO插件肯定有这个功能的,并且默认是开启的。通过:域名/sitemap_index.xml即可访问,当然 域名/sitemap.xml是会自动跳转到 sitemap_index.xml 的。例如:https://www.zhanzhangb.com/sitemap_index.xml

Yoast SEO的设置中也可以自定义哪些类型的URL出现在Sitemap中,SEO – 搜索外观 的设置中:“在搜索结果中显示文章?” 选项,如下图:

robots.txt详解

robots.txt也称为robots协议,就是网站可以申明哪些内容是不希望被搜索引擎抓取的。基本上所有常见的搜索引擎都会遵循robots协议,只需要在网站的根目录下创建一个 robots.txt 文件即可,Wordpress网站常见的 robots.txt 文件的内容示例:

User-agent: *

Disallow: /wp-admin/

Disallow: /*?p=*

Allow: /wp-admin/admin-ajax.php

Sitemap: https://www.zhanzhangb.com/sitemap_index.xml以上内容的意思是网站允许所有搜索引擎抓取,申明禁止抓取/wp-admin目录及目录下所有内容、禁止抓取所有带“?p=”字符串的URL, /wp-admin目录中的admin-ajax.php文件允许抓取。最后一行是指定Sitemap文件的路径。

其实robots.txt的语法特别简单,主要有以下几个:

- User-agent: 用于告诉识别蜘蛛类型。例如:User-agent: Baiduspider就是 指百度搜索蜘蛛,User-agent: Googlebot就是指谷歌的蜘蛛。

- Disallow: 申明禁止抓取的指定目录或文件 。

- Allow: 申明允许抓取的指定目录或文件,默认是允许抓取所有。

- Sitemap: 提供网站地图,方便蜘蛛抓取网站内容。

- 通配符: * 匹配0或多个任意字符。

- 终止符: $ 可以匹配以指定字符结尾的字符。

- User-agent,Allow,Disallow,Sitemap的首字母都是大写的。

- User-agent,Allow,Disallow,Sitemap的冒号后面都是有空格的,没有写空格直接写接下来的内容会出错。

常见的搜索引擎蜘蛛User-agent:

- 所有搜索引擎蜘蛛:User-agent: *

- 百度搜索引擎蜘蛛:User-agent: Baiduspider

- 谷歌搜索引擎蜘蛛:User-agent: Googlebot

- 必应搜索引擎蜘蛛:User-agent: Bingbot

- 搜狗搜索引擎蜘蛛:User-agent: sogou spider

- 360搜索引擎蜘蛛:User-agent: 360Spider

例如要禁止百度搜索引擎抓取全部内容,而允许其它搜索引擎抓取全部内容,写法如下:

User-agent: Baiduspider

Disallow: /

User-agent: *

Disallow: 有关SEO的一些总结

其实SEO并不神秘,也没有部分站长想得那么复杂。“ 网站是给人浏览的,而SEO只是帮助搜索引擎更方便的了解网站及阅读内容,人的体验比搜索引擎的体验更重要 ”,这一句话请所有站长都牢记。以下误区大家要注意避免:

为什么花了很多时间研究SEO,且做了大量工作,而网站流量就是上不去?

这就是我们所说的,网站最重要的是浏览者的体验,SEO只是辅助搜索引擎的。而且随着搜索引擎的技术与算法越来越先进,对于那些过分注重SEO而忽略了用户体验的网站,不仅没有任何好处还有可能被搜索引擎“处罚降权”。有一些用户体验和内容做得非常好的网站,甚至没有刻意采用SEO手段,依然获得了搜索引擎的青睐。

搜索引擎友好度是个什么概念?

搜索引擎通过不断的升级技术和算法,努力的模仿人的体验感知,所以网站的内容质量、访问速度、页面布局、界面美观等因素都会影响到体验度,换言之就是搜索引擎的友好度。

既然搜索引擎在模仿人,那么SEO还有必要吗?

搜索引擎是在模仿人,但目前没有哪个搜索引擎的技术完全达到与人一样的感知,所以通过SEO来帮助搜索引擎读懂我们的网站是有必要的,只是我们在SEO的过程中不要本末倒置就行。

很多主机商宣称网站使用独立IP能对SEO带来帮助,这是真的吗?

这个好比你有两个朋友,一个住在人员特别密集的平民窟,那里三教九流什么人都有,还有一个住在独门独院的庭院中,试问你喜欢常去谁家做客呢?当然这只是一个比喻,实际情况也并没那么严重,只要和你共享IP的其他网站并没有被搜索引擎K站(搜索引擎宣判死刑),基本上影响不大,不过有条件用独立IP还是更稳妥,就算是共享IP,咱们也尽量选择高端小区居中。

网站加载速度是SEO的重要指标,有什么好的建议吗?

搜索引擎的蜘蛛爬行各网站的时候,也是讲究效率的,假设A、B两个网站,同样是1000个页面,A站平均页面的抓取时间为1秒,而B站的平均页面的抓取时间为3秒,如果蜘蛛在两个网站都花15分钟来抓取内容,A站基本上全站抓取完,而B站连一半都没抓取完。

影响网站加载速度的因素有很多,例如:服务器性能、网络带宽、线路质量、WEB环境的执行效率、网页中的代码尤其是JS代码等,Wordpress网站可阅读《WordPress建站流程(四)速度优化》文章了解如何优化速度。

什么样的内容才是搜索引擎认为的优质内容?

首先当我们做为读者,什么内容是我们喜欢阅读的,那么它就是优质内容。还有就是原创内容是各搜索引擎喜欢的,哪家搜索引擎都不希望一搜一堆相同的内容。

具体而言,内容要符合网站的主题,可读性高,同时有观点和核心思想。

SEO中还有哪些要注意的事项?

1、必须友好支持移动设备访问。

2、全站开启HTTPS,并做好HTTP到HTTPS的301跳转。

3、定期检查有没有死链,如果页面更改了URL,要做301跳转。

4、网站的加载速度中DOMContentLoaded的时间不要超过1000ms,最好在500ms内。 DOMContentLoaded时间可在浏览器中通过F12查看。

5、网站的安全状况需要定期检查。

6、网站定期更新高质量的内容。

本文收集自互联网,转载请注明来源。

如有侵权,请联系 wper_net@163.com 删除。

评论功能已经关闭!