WordPress建站教程2:robots的写法

很多站长喜欢WordPress来建站,因为更利于SEO优化,蜘蛛爬取网站的时候,一般先查看我们的roobots…

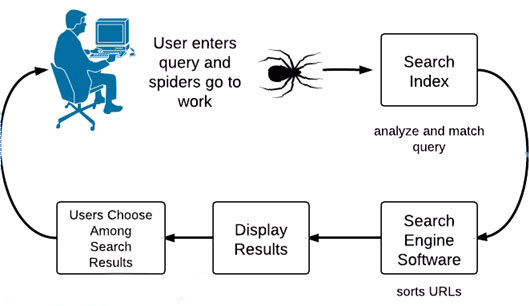

很多站长喜欢WordPress来建站,因为更利于SEO优化,蜘蛛爬取网站的时候,一般先查看我们的roobots文件,roobots文件中不允许爬行的文件及文件夹,它就不会去查看,所以我们在做WordPress网站的时候要先设置robots文件。今天就分享wordpress建站教程2:robots的写法。

其实,wordpress已经给网站做了一个默认的tobots,它禁用了它自己的主要核心文件及文件夹不允许蜘蛛访问。但是,我们自己的网站,有时还有其它文件或文件夹要禁止蜘蛛爬行,这时,我们就要对robots文件进行修改。

这里为网站robots的写法做一个简单的解释吧:

User-agent: * 表示允许所有的搜索引擎爬行;

Disallow: /wp-admin/ disallow表示不允许,即不允许爬行wp-admin 这个文件夹 。

Disallow: /wp-* 禁止抓取WordPress程序目录

Disallow: /*.css$ 禁止抓取全站所有css文件

Disallow: /*.js$ 禁止抓取网站所有js文件

Disallow: /*/attachment/* 禁止抓取网站所有附件内容

Disallow: /*/comment-page-* 禁止抓取文章页的评论分页

Sitemap: https://www.vpsche.com/sitemap.html 允许爬行网站地图文件

你也可以参考一下别的知名网站的robots写法,一般都大同小异。

到这里,wordpress网站的robots文件设置方法就结束了。

本文收集自互联网,转载请注明来源。

如有侵权,请联系 wper_net@163.com 删除。

评论功能已经关闭!